Gmail lit vos emails pour entraîner son IA et ce n’est pas juste un détail technique

Il ne s’agit pas d’une énième mise à jour anodine. Depuis quelques jours, plusieurs utilisateurs de Gmail découvrent que leurs paramètres ont été modifiés par défaut pour permettre à Google d’analyser le contenu de leurs emails et de leurs pièces jointes afin d’entraîner ses modèles d’intelligence artificielle. Traduction : vos correspondances privées deviennent matière première pour Gemini, la nouvelle IA maison. Et si vous ne touchez à rien, tout est activé.

Officiellement, Google veut améliorer Smart Compose ou réponses intelligentes – ces suggestions automatiques qui finissent vos phrases. Officieusement ? C’est un changement profond de paradigme sur ce que nous considérons encore comme « nos » données.

Quand la case « confidentialité » est cochée par défaut contre vous

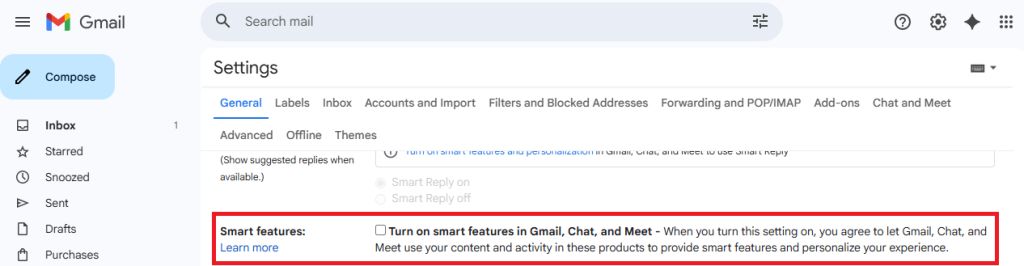

Le plus troublant ici n’est pas l’usage de l’IA. C’est la méthode. Google a activé ces paramètres sans vous demander votre avis explicite. Pas de pop-up intrusif. Pas de fenêtre d’acceptation. Juste une case cochée, dans les tréfonds des paramètres, que vous ne découvrirez que si vous allez activement la chercher.

C’est du dark pattern : une manipulation douce qui repose sur l’inertie des utilisateurs. On parie que vous ne changerez rien. Et Google gagne ce pari dans 99% des cas.

Une IA qui apprend de vos secrets

Soyons clairs : ces modèles sont entraînés à partir du contenu de vos messages, de vos fichiers joints, de vos habitudes d’écriture. Même si Google promet une anonymisation et des traitements sécurisés, cela reste un accès direct à ce que vous considérez comme privé.

Cela pose trois problèmes majeurs :

- Consentement biaisé : vous n’avez pas réellement accepté. On vous a fait consentir par défaut.

- Opacité fonctionnelle : impossible de savoir comment vos données sont utilisées, où elles sont stockées, par qui elles seront relues, corrigées, ou exploitées.

- Effet boule de neige : si Google le fait, les autres suivront. Et demain, ce seront vos messages pro, vos documents légaux, vos discussions médicales.

Ce que cela dit du futur de notre rapport au numérique

Ce n’est pas une question technique. C’est une question de civilisation numérique.

Nous vivons une époque où la technologie avance plus vite que les garde-fous législatifs, éthiques ou citoyens. Quand vous utilisez Gmail, vous n’êtes pas juste un client : vous êtes un vecteur d’entraînement pour des IA qui vous connaissent mieux que vous-même.

On nous promet des gains de productivité, des assistants plus pertinents, une vie numérique plus fluide. En réalité, on nous retire la souveraineté cognitive sur ce que nous écrivons, pensons et partageons.

Comment réagir ? Ce n’est pas qu’une question de paramètre

La plupart des articles vous diront « comment désactiver » cette fonctionnalité. C’est utile. Mais pas suffisant.

Ce qu’il faut, c’est élever le niveau du débat public autour de ce qui doit rester inaliénable dans un monde numérique.

- Vos messages ne devraient jamais être analysés sans votre accord explicite, et éclairé.

- Une IA ne devrait pas pouvoir être nourrie de conversations privées sans un consentement individuel.

- Les géants du numérique doivent assumer des devoirs de loyauté face à des utilisateurs qu’ils savent passifs, parfois vulnérables, souvent peu informés.

Une culture numérique à (re)bâtir

Ce sujet rejoint ce que je défends dans mon livre Être en cybersécurité : on ne protège pas ce qu’on ne comprend pas.

Chaque fois qu’une plateforme pousse ses utilisateurs vers plus de simplicité au détriment du contrôle, elle entame leur autonomie. Et chaque fois que l’on cède sur ces petits détails comme une case cochée ici, une autorisation vague là ; on construit une société de dépendance technologique.

Or, une démocratie numérique saine repose sur trois piliers :

- La transparence dans les règles du jeu,

- Le consentement éclairé des utilisateurs,

- La possibilité de refuser sans pénalité fonctionnelle.

Alors, que faire ?

- Allez dans vos paramètres Gmail et désactivez les fonctions « Smart Features » et « Workspace Smart Features » (elles sont dans deux endroits différents).

- Informez vos proches, vos collègues, vos clients. Si vous gérez des données sensibles pour d’autres, vous avez une responsabilité.

- Posez la question à vos prestataires numériques : où vont mes données, qui les lit, pour quoi faire ?

- Militez pour une régulation européenne forte sur l’usage des données personnelles à des fins d’entraînement IA. Le RGPD était une première étape. Il est temps de passer à la suite.

Ce n’est pas une bataille contre l’intelligence artificielle. C’est une bataille pour une intelligence humaine du numérique.

Parce qu’un outil, aussi puissant soit-il, ne devrait jamais décider pour vous ce qu’il fait de votre vie privée.